- Intelligente Assistenten

- Was sind Intelligente Assistenten?

- Beispiel: Knowledge Navigator

- Beispiel: HyperCard

- Beispiel: Guides 3.0

- Beispiel: Olga

- Beispiel: Welbo

- Beispiel: SmartKom

- Beispiel: Fahrerassistenzsysteme

- Diskussion

- Quellen

- Virtuelle Realität

- Second Life

- RFID-Technologie

- Gesundheitswesen

- Kriminalistik

- Biometrie

- Virtuelle Körper

Was sind Intelligente Assistenten?

In dem Themenkomplex „Was sind Intelligente Assistenten“ soll ein Eindruck davon vermittelt werden, was einen Intelligenten Assistenten überhaupt ausmacht. Dieser Eindruck soll durch Beispiele vertieft und schließlich im letzten Teil „Diskussion“ kritisch hinterfragt werden.

Die Idee, die hinter dem Intelligenten Assistenten steht

Die Technik der heutigen Zeit gestaltet sich zunehmend komplexer. So sind Computerprogramme aufgrund der Komplexität der Software häufig nicht einfach zu erlernen. Das Programm passt sich nicht dem Benutzer an, sondern es wird von Benutzer verlangt sich an das System anzupassen. Dies erfordert nicht nur einen hohen Lernaufwand und die Erkenntnis, dass ein Programm meist nicht komplett zu erlernen ist sondern auch einen großen Zeitaufwand zum Lösen einer Aufgabe. An dieser Stelle entstand die Idee eines Intelligenten Assistenten, der dem Benutzer helfend zur Seite steht.

Was bedeutet „Intelligenter Assistent“?

Um zu erläutern was ein Intelligenter Assistent ist, bietet es sich an zunächst die Begrifflichkeiten zu klären. Bei dem Begriff des „Assistenten“ handelt es sich um einen Gehilfen, einen Beistand oder sogar Mitarbeiter. Die Definition des Begriffes „Intelligenz“ gestaltet sich allerdings etwas komplizierter. Dieser bezeichnet die Klugheit, geistige Begabung oder Gesamtheit der Kopfarbeit. Eigenschaften, die man sich bei einer „Maschine“ wohl schwer vorstellen kann. Die Intelligenz zeigt sich daher eher in den Eigenschaften, die der Intelligente Assistent aufweist. Diese werden im nächsten Abschnitt „Eigenschaften des Intelligenten Assistenten“ genauer erläutert. Es lässt sich zunächst das Fazit ziehen, dass ein Intelligenter Assistent als Mitarbeiter anzusehen ist und nicht nur als ein Werkzeug!

Eigenschaften des Intelligenten Assistenten

Damit ein Intelligenter Assistent eine wirklich effektive Hilfe für den Benutzer darstellt ist es zunächst wichtig, dass keine Unterbrechungen durch störende oder überflüssige Hinweise stattfinden. Des Weiteren findet die Unterstützung auf zwei verschiedenen Ebenen statt: der Benutzerebene (durch die Benutzerführung) und der Systemebene. Auf der Systemebene kann die Hilfe passiv, durch lediglich hinweisende Funktion (z.B. Warnhinweise), oder aktiv, indem der Assistent selbstständig eingreift, stattfinden.

Der Intelligente Assistent erledigt selbstständig Aufgaben, indem er routinehafte Einzelfunktionen kombiniert, um den Nutzer von diesen zu befreien. Hierbei ist es wichtig, dass der Assistent in Bezug auf Wissen und Kommunikation an den Nutzer angepasst ist. Der Intelligente Assistent stellt einen sichtbaren, kommunikativen Helfer dar, der mit folgenden Eigenschaften ausgestattet ist:

er ist autonom: er arbeitet weitgehend unabhängig von Benutzereingriffen

er ist reaktiv: er reagiert auf Änderungen in der Umgebung

er ist sozial: er kommuniziert nicht nur mit anderen Systemen, sondern auch mit dem Benutzer.

er ist lern- & anpassungsfähig: er lernt aufgrund zuvor getätigter Entscheidungen beziehungsweise Beobachtungen.

er ist proaktiv: er löst Aufgaben aus eigener Initiative

In den folgenden Rubriken „Beispiel: …“ haben Sie nun die Möglichkeit mehr über einzelne, unterschiedliche Intelligente Assistenten zu erfahren.

Gehe zu: Themenauswahl, Informationen zum Text

Beispiel: Knowledge Navigator

Zusammenfassung

Die Vision des Knowledge Navigators beschrieb John Scully (Apples CEO 1983 – 1993) erstmals in seinem Buch Odyssey (1987). Er war Sculleys Vision des PC für das 21. Jahrhundert. Das Konzept des Knowledge Navigators wurde 1987 in einem Video mit dem Namen „The Knowledge Navigator: Technologies to Get Us There and Beyond“ präsentiert. Dieser legendäre Film ist auch nach 20 Jahren immer noch sehenswert, klicken sie hier um sich ihn anzusehen.

Der Knowledge Navigator (Copyright by Apple)

In diesem Video wird ein Intelligenter Assistent vorgestellt, welcher einem Professor hilft, seine Vorlesung vorzubereiten. Da dieses Video 1987 gedreht wurde, das Szenario allerdings im Jahre 2014 stattfindet, erkennt man sehr schnell, dass es sich hierbei um eine, bis dahin technisch noch nicht realisierte, Vision handelt.Der Knowledge Navigator ist ein interaktiv kommunizierender Assistent, welcher durch Nutzung des World Wide Web seinen Verwendern die Kommunikation rund um den Globus erlaubt. Er ist mit Informations – Datenbanken verbunden, die die Verknüpfung verschiedener Ideen untereinander möglich macht, sowie einer entsprechenden „Intelligenz“, welche ihn nicht als rein technisches Hilfsmittel ausweist, sondern als eigenständigen Bearbeiter von Aufgaben. Diese Visionen sind grundlegend für elementare Erfindungen in der Informatik.

Was kann der Knowledge Navigator?

Der Knowledge Navigator wirkt zunächst wie ein verbessertes, persönliches „Outlook“. Der Assistent gibt Email und Anrufnachrichten wieder, die der Professor durch seine Abwesenheit verpasst hat. Außerdem übernimmt er die Funktion eines Terminkalenders, welcher ihn an alle anstehenden Tagespunkte erinnert. Weiterhin ist der Knowledge Navigator eine verbesserte Suchmaschine, die, wenn gewünscht, sowohl in den persönlichen Dateien, als auch im Internet nach relevanten Ergebnissen sucht. Dabei verwendet er mehrere Datenbanken, die auch „Randinformationen“ wie Freundschaften zu anderen Professoren beinhalten. Der Knowledge Navigator übernimmt auch die Funktion eines Telefons, in dem er auf Verlangen den gewünschten Gesprächspartner anruft und Nachrichten hinterlässt, falls diese nicht erreichbar sind.

Die ganze Zeit „versteht“ dieser intelligente Assistent, was der Professor genau haben möchte und versorgt ihn mit entsprechenden Informationen. Er reagiert aber nicht nur auf sprachliche Eingaben, sondern verfügt auch über einen Touchscreen. Während einem Video-Telefonat versorgt der Knowledge Navigator seinen Professor mit vergessen scheinenden Daten und hilft bei der Übertragung und Veränderung von Grafiken und Videos. Die letzten, in dem Video gezeigten, Aufgaben sind Ausdrucke anfertigen, sowie eigenständig Telefonate führen und Termine vereinbaren. Wie bewältigt er diese Aufgaben? (Technologien)

Sculley beschreibt 5 Schlüsseltechnologien, die dem Knowledge Navigator zugrunde liegen sollten:

- Fortschrittliche Kommunikationstechnologie, die weltweit Rechner und Datenbanken miteinander verbindet und den Anwendern breitere Informationspfade zur Verfügung stellt. Diese Schlüsseltechnologie ist heutzutage durch das Internet schon sehr weit fortgeschritten. 1987 war zwar schon bekannt, dass man über Netzwerke zwischen Rechnern kommunizieren konnte, allerdings war zu dieser Zeit noch keine weltweite Verknüpfung umgesetzt.

- Echtzeit- Animationen in 3D, die es erlauben, komplexe Modelle zu visualisieren. Auch diese Schlüsseltechnologie ist in der heutigen Zeit realisiert. Allerdings steckte 1987 die Graphik noch in ihren Anfängen und der Speicherplatz fehlte. Daher war es zu der Zeit noch nicht denkbar solche Animationen umzusetzen.

- Verbesserte Datenbank- Technologien als Schlüssel zu umfassenden Informationssystemen. Diese Technik ist heutzutage anwendbar und wird im Laufe der Zeit noch mehr steigen, im Bezug auf die hinzukommenden Datenmengen. Denn die Digitalisierung aller wichtigen Erkenntnisse des Menschen ist eine wichtige Perspektive des 21. Jahrhunderts und bedarf im Bezug auf den verbrauchten Speicher, Hardware- und Datenbank(Software)- Erneuerungen.

- Hypermedia, die Verbindung von Text, Grafiken, Ton und bewegten Bildern, die den zukünftigen Computer- Anwendern intuitiv den Weg durch riesige Informations-Sammlungen weißt. Diese Beschreibung trifft auf die Hypertext- Systeme zu, die die Grundlage für HTML stellen. Als erstes richtig funktionsfähiges Hypertextsystem wird das Hypercardsystem der Firma Apple gesehen. Die Umsetzung des Hypertextsystemes im Bezug auf das Internet, wie es im Video zu sehen ist, wurde erst 1989 durch Tim- Berner- Lee aufgebaut und führte dann zum heute bekannten WWW (World Wide Web).

- Künstliche Intelligenz als Schlüsseltechnologie. Die künstliche Intelligenz erlaubt die Verwendung von Agenten die sowohl persönliche Vorlieben der Anwender erkennen als auch Strategien vorschlagen und damit zur Steigerung der Produktivität beitragen. Dieser Punkt kann noch nicht komplett umgesetzt werden, da die Anpassung eines Systems an den Nutzer zwar schon möglich ist, aber nicht in diesem komplexen Sinne. Besonders im Punkt der semantischen Spracherkennung ist die heutige Technik noch nicht am Ziel.

Bewertung

Wenn man bedenkt, dass die Vision des Knowledge Navigators schon 20 Jahre alt ist, muss man zugeben, dass Scullys Ideen den Test der Zeit bestanden haben. Viele Elemente sind heutzutage Routine und werden von vielen Menschen genutzt. Auch wenn nicht alle Visionen vollständig umgesetzt wurden waren sie wichtig für die Technologien, die durch sie angeregt wurden. Außerdem sagten sie die Änderung der Rolle des Computers als „persönliches“ Produktivitäts-Werkzeug zum Austausch und Transfer von Informationen voraus. Manch einer meint, dass sich google durch Google Talk, Google News, Google Earth, Google Books… den Knowledge Navigator als Vorbild genommen hat.

Nun muss man sich fragen, ob diese Technologien überhaupt wünschenswert sind. Wären wir Menschen bereit, mit einem intelligenten Assistenten zu kommunizieren? Was wird dieser Assistent noch alles können? Wird der Mensch, in dem Beispiel ein Professor, irgendwann überflüssig, weil der intelligente Assistent alles alleine machen kann? Wie abhängig werden wir von intelligenten Assistenten sein? Was passiert, wenn diese einen technischen Defekt haben?

Diese und weitere Fragen werden in dem Themenkomplex „Diskussion“ noch angesprochen.

Hier gibt es das Video zu diesem Thema.

Gehe zu: Themenauswahl, Informationen zum Text

Beispiel: HyperCard

Dieser Assistent ist der Vorgänger für HTML und Vorreiter für alle neueren Hypertext-Systeme. HyperCard gehört nicht zu den interaktiven Assistenten. Er führt keine interaktive Kommunikation mit den Benutzern durch.

Der Assistent HyperCard hat den Namen „Phil“ und soll seinen Benutzer durch ein Informationssystem führen. Dies wird in unserem Videobeispiel verdeutlicht. Im Video wird der Unterschied in der Bedienung mit und ohne „Phil“ anhand der Beispiele „Olympische Spiele 1992“ (mit Phil) und „Olympische Spiele 1988“ (ohne Phil) deutlich.

Bill Atkinson entwickelte HyperCard 1987 für die Firma Apple, welche es in diesem Jahr auch veröffentlichte. HyperCard war das erste nutzbare Hypermedia – Autorensystem für einen größeren Nutzerkreis als gewöhnlich. Ende der 80er und Anfang der 90er Jahre war HyperCard die bevorzugte Entwicklungsumgebung für Hypermedia-Lernsysteme.

Wie oben erwähnt ist dieses System der Vorreiter für HTML und zeigte als erstes Programm die Möglichkeiten von Hypertext-Systemen auf. Nach HyperCard als erstes Hypertext-System erschienen mehrere Systeme, die auf HyperCard aufbauten. Dieses System wurde im weiteren Verlauf durch den Assistenten Phil erweitert. Der sogenannte Assistent „Phil“ sollte die Benutzung des HyperCardsystems für den Benutzer leichter machen. Allerdings kann „Phil“ nur Befehle ausführen. Er kann keine interaktive Kommunikation mit dem Benutzer führen, wie es z.B. Welbo kann. Phil reagiert auf Schlagwörter, dass heißt, er hat noch keine semantische Interpretation beim Auswerten des gesprochenen durch den Benutzer, sondern reagiert auf feste Befehlsfolgen durch die Sprache.

Der Assistent Phil

Der Assistent Phil hat ein menschlich- angepasstes Aussehen in Form einer Zeichentrickfigur. Er reagiert auf Schlagwörter. Phil versteht die Eingabe nicht, da (wie oben erwähnt) seine Sprachdatenbank sehr eingeschränkt ist. Die Kommunikation mit der Zeichentrickfigur Phil findet also nur verbal akustisch statt. Phil erinnert stark an Voice- User- Interfaces, da er nur Befehle ausführt die auch per Maus ausführbar wären. Diese Umsetzung im Bezug auf die Kommunikation ist aber sehr realitätsnah und nicht wie in unserem Videobeispiel zu „Knowledge Navigator“, ein Prototyp der in diesem Umfang noch nicht herstellbar wäre. Phil führt den Benutzer in diesem Video durch eine dreidimensionale Stack - Map. Der gesamte Aufbau von HyperCard (inklusive graphischer Darstellung von Karteikästen und Links zwischen Karteikarten) wird hier gezeigt. Daher war dieser Assistent auch denkbar, für aktuelle Browser- Anwendungen und er könnte so auch den Benutzer durch das World Wide Web führen. Zudem ist dieser Assistent gut geeignet für das Zeigen von Informationssystemen. Dieses Vorgehen erinnert sehr stark an heutige Browser. Dieser Assistent geht sehr routiniert mit dem Betriebssystem, dem HyperCardsystem und anderen Applikationen wie Grafikprogrammen um. Zudem ist zu erwähnen, dass der Assistent große mathematisch-physikalischen Kenntnisse vorzuweisen hat.

Damit das Informationssystem HyperCard verständlicher wird, muss zunächst ein kleiner Überblick über das gesamte HyperCardsystem gegeben werden.

Das HyperCardsystem

Man muss sich vorstellen, dass HyperCard eine Art „Karteikarten“ erstellt. Diese werden dann in „Stapel“ zusammengefasst. Diese Karteikarten lassen sich einfach zu vernetzten Strukturen verknüpfen. HyperCard ist somit ein einfach zu bedienendes "Datenbanksystem". Mit seiner Skriptingsprache „Hypertalk“ kann der Benutzer einfache Anwendungen ohne große Vorkenntnisse und mit geringem Lernaufwand erstellen.

HyperCard erstellte Konzepte, welche die Revolution der objektorientierten Programmierung erst möglich machten, da der HyperCardaufbau an „Stacks“, also an Objekte gebunden ist.

Aufbau und Einsatzmöglichkeiten

HyperCard ist vielseitig und kann als Datenbank, Programmierumgebung oder auch als ein Multimedia-Autorensystem gesehen oder genutzt werden. Das Basisdokument ist jeweils der „Stapel“ bzw. der „Stack“. HyperCard kann in einem einzigen Feld die Angaben von bis zu 70 Ansprechpartner (also bis zu 30.000 Zeichen) speichern. Diese können dann gezielt abgerufen werden.

Datenbank:

HyperCard erstellt einen Karteikasten mit vielen Karteikarten. Die Grundeinheit von HyperCard wird „Stack“ genannt, also ein Karteistapel. Informationen können in jeglicher Form in den Stacks abgelegt werden. Dann können die einzelnen Karteikarten miteinander verknüpft bzw. verlinkt werden (Hypertext) und einfach in einen beliebigen Stack gelöscht oder hinzugefügt werden, ohne andere Strukturen zu zerstören. Zusätzlich bietet HyperCard einen eingebauten Suchalgorithmus, um dem Benutzer schneller seine Informationen zu liefern.

Programmierumgebung:

Die eingebaute Programmiersprache in HyperCard (HyperTalk) ist für viele Benutzer das Wesentliche an diesem System. Sie ermöglicht fast jede denkbare Anwendung in dem System zu programmieren. Die Benutzer erwähnen, dass HyperTalk wesentlich komplexer sei als Basic (eine andere Internetsprache), da sie zusätzlich noch objektorientierte Komponenten beinhalte. Alles was interaktiv in HyperCard durch Maus und Tastatur erstellt wird, kann in HyperTalk programmiert werden. In unserem Videobeispiel wird allerdings nur durch ein Graphiktool die Umdrehung einer Eiskunstläuferin mathematisch analysiert. Dieses Graphiktool wurde mit Hypertalk erstellt.

Multimedia-Autorensysteme:

HyperCard ist zudem ein Multimedia-Autorensystem. Sehr früh wurden CBT - Programme (Computer - Based Training - Programme) für den Schulbereich entworfen und verwendet. Die Verwendung von Links ist eine weitere Möglichkeit des Systems. Dies ist vergleichbar mit Verweisen in einem Lexikon. Die Multimedia-Autorensysteme sind jedoch wesentlich komplexer und automatisiert.

Bewertung

Die Entwicklung von HyperCard wurde schon 1998 eingestellt. Es gibt allerdings noch einige Unternehmen, die sogenannte Open – Source – Lösungen anbieten, welche auf dem HyperCardsystem aufbauen. HyperCard war nie ein interaktiv kommunizierender Assistent. Der Assistent Phil ist weder besonders autonom noch reaktiv oder sozial. Er kann nicht direkt mit dem Benutzer kommunizieren. Er ist Vorreiter für HTML und alle anderen wichtigen interaktiv kommunizierenden Assistenten und ist somit ein wichtiger Bestandteil für die darauffolgenden intelligenten Assistenten.

Hier gibt es das Video zu diesem Thema.

Gehe zu: Themenauswahl, Informationen zum Text

Beispiel: Guides 3.0

Intelligente Assistenten bemühen sich hauptsächlich um eine bessere Darstellung von Informationen. Guides 3.0 besitzt gleich vier Assistenten: Einen Systemassistenten und drei historische Assistenten (Indianer, Siedlerin, Trapper), die mit verschiedenen Funktionen und Sichtweisen versuchen, den Benutzer durch die nordamerikanische Geschichte zu führen. Der Systemassistent führt den Benutzer durch das System, weiß wie es funktioniert und hilft bei der eingebauten Suchfunktion. Er erklärt das Menu der Suchmaschine.

In der Suchmaschine befinden sich schon fertige Stichwörter zu einzelnen Themen, die der Benutzer nur noch per „Drag and Drop“ auswählen und anklicken muss. Zudem ist es möglich, mehrere Stichwörter zusammen einzugeben. Dabei werden Links in real- time aufgelistet, die diese Schlagwörter enthalten.

Durch Favoritenlisten kann der Benutzer seine beliebtesten Schlagwörter angeben und die Medien festlegen, die er für die Visualisierung wünscht.

Nun wählt der Benutzer ein Thema aus und erhält dazu eine schriftliche Einführung. Ihm werden Links aufgezeigt, welche das Thema zusätzlich noch vertiefen. Bei Bedarf können diese Informationen auch abgerufen werden.

In diesem Bereich kommen nun die drei historischen Assistenten ins Spiel. Außer der Suchmaschine und der Favoritenliste gibt es noch eine andere Möglichkeit, um an gewünschte Themen zu gelangen. Ein Benutzer der nur eine kurze Information über ein Thema wünscht, sollte die Suchmaschine wählen und sich dann bei größerem Interesse zusätzlich die Gesichtspunkte der Assistenten anhören. Die drei historischen Assistenten dagegen vertiefen das Thema zusätzlich und bieten dem Benutzer auch dann viele Informationen, wenn er vorher noch nichts über das gesuchte Thema wusste.

Zwei verschiedene Auswahlmöglichkeiten

(unterstützt durch die historischen Assistenten)

- Jeder Guide ist am Anfang direkt anwählbar und der Benutzer kann sich sofort Videos zu diesem Thema anschauen.

- Wenn der Benutzer ein Thema wählt, erscheint ein Textdokument über dieses Thema. Dabei verhalten sich die historischen Assistenten je nach Thema verschieden:

- der Assistent stellt sich schlafend. Dies geschieht, wenn der Assistent nichts zu diesem Thema beitragen kann.

- der Assistenten wacht wieder auf. ( es können auch mehrere Assistenten gleichzeitig aufwachen) Dies geschieht, wenn der Assistent etwas zu einem Unterpunkt des Themas weiß.

- der Assistent meldet sich, dies geschieht wenn er etwas direkt zum Thema beitragen kann.

Diese Möglichkeiten sind in den Assistenten fest implementiert. Jeder Assistent präsentiert eine verschiedene Menschengruppe. Somit stellt dieses Projekt eine Alternative zu den bisherigen geschichtlichen Datenbanken dar. Durch subjektiv Meinungen zu den Themen die der Benutzer erfährt, wird das Programm auch sehr unterhaltsam. Deshalb wurde dieses Projekt auch für den Schuleinsatz vorgesehen. In dem Video wird erwähnt, dass Geschichte besser zu erlernen ist, wenn sie durch persönliche Geschichten von Angehörigen erzählt wird.

Verschiedene Sichtweisen

Jeder Guide präsentiert eine bestimmte amerikanische Menschengruppe und deren Sichtweise auf die Geschichte. Diese digitalen Charaktere melden sich immer, wenn sie ein Thema besonders "interessant" finden (siehe oben: 2 und 3 Möglichkeit der Assistenten).

Da es schwer und weniger unterhaltsam ist verschiedene Sichtweisen eines Ereignisses in einem Buch darzustellen, bietet Guides 3.0 einige Vorteile im Bezug auf Informationen über die Geschichte. Durch Guides 3.0 kann ein Projekt viel komplexer und übersichtlicher gestaltet werden als in einem Buch. Dem Benutzer soll in diesem Beispiel die Geschichte übersichtlich und informativ näher gebracht werden. Dabei ist es besonders wichtig, dass diese subjektiven Geschichten aus verschiedenen Sichtweisen den geschichtlichen Kontext verstärken. Durch Emotionen der Assistenten wird die Aufmerksamkeit des Benutzers zusätzlich gesteigert. Um noch mehr Aufmerksamkeit des Benutzers zu erlangen werden verschiedene Medien benutzt. Durch die Stärkung der bildlichen Vorstellungskraft soll besonders bei Kindern durch Guides 3.0 größere Lernerfolge erzielt werden, da das Lernen spielerisch umgesetzt werden kann.

Bewertung

Der Einsatz der vier Assistenten wäre auch in anderen Bereichen denkbar, die hauptsächlich zur Unterstützung des Lernens gedacht sind. Durch Guides 3.0 erhält der Benutzer einfach ein einfaches und schnelles Suchsystem, welches ihm die Möglichkeit bietet sich über ein Thema mit verschiedenen Sichtweisen zu informieren.

Guides 3.0 ist wesentlich moderner und weiterentwickelt als HyperCard. Durch die hochgradig vernetzten und komplexen Systeme bei denen es sehr viele Querverbindungen gibt, ist Guides 3.0 sehr geeignet als Navigations- und auch Explorationshilfe. So wird „Guide“ auch als Städteführer angeboten (z.B. für Wien). Wichtig ist, dass Guides 3.0 dabei noch mehr bietet. Die Assistenten bieten eine subjektive Position zu bestimmten geschichtlichen Fakten, welches sehr menschlich ist. Ähnlich wie bei HyperCard ist dieser Assistent nicht interaktiv. Der Benutzer kann keine Fragen an das System bzw. an die menschlich gestalteten Assistenten richten.

Fraglich ist jedoch, ob diese Guides ein Ersatz für menschliche Erzähler sind. Zudem könnten die Benutzer (vor allem Kinder, für die Guides 3.0 als Lernprogramm empfohlen wird) durch die subjektiven Meinungen der Assistenten verwirrt oder zu sehr beeinflusst werden.

Gehe zu: Themenauswahl, Informationen zum Text

Beispiel: Olga

Bei Olga handelt es sich um einen multimodalen, interaktiven Informationsassistenten, der den Benutzer durch bestimmte Themengebiete führt. Er wurde 1997 (???) vom CID (Center of IT Design, KTH, Stockholm) in Schweden erschaffen.

Wer oder was ist Olga?

Olga in Aktion (Screenshot aus: Olgafilm)

Olga ist ein interaktiver Intelligenter Assistent, der über Mikrowellen informiert. Es wurde speziell dieses Themengebiet ausgewählt, da hier das nötige Vokabular limitiert und somit nicht zu umfangreich ist. Der Benutzer tritt über die Sprache in eine direkte Kommunikation mit Olga, die als Comicfigur auf dem Bildschirm zu sehen ist. Olga beantwortet allerdings nicht nur Fragen des Benutzers, sie ist auch in der Lage auf weitere Möglichkeiten hinzuweisen wie zum Beispiel: „Die ausgewählten Mikrowellen besitzen keinen digitalen Timer. Möchten Sie über die Vorteile von Mikrowellen mit digitalen Timern erfahren?“.Die Multimodalität Olgas zeigt sich darin, dass die einzelnen Module nie direkt, sondern immer über einen Server miteinander kommunizieren. Diese Trennung macht das Ändern oder Ergänzen von Modulen somit einfacher.

Bedeutung der Kommunikation

So einfach wie die Kommunikation auf den ersten Blick erscheint, ist sie allerdings nicht. Treten wir mit anderen Menschen in eine Konversation, so ist für unser Verstehen nicht nur das gesprochene Wort von Bedeutung. Andere Faktoren wie die Betonung, Gestiken und Mimiken spielen bei der Interpretation einer Nachricht eine wesentliche Rolle. Auch das Computersystem muss das Gesprochene in einen Kontext bringen.

Olgas Aussehen

Olga (Screenshot aus: Olgafilm)

Die Darstellung von Olga als Comicfigur bot sich an, da man auf diese Art und Weise zu hohen Erwartungen auf Seiten des Benutzers entgegenwirken kann. Der überdimensional große Kopf wirkt, allein durch die großen Augen, sympathischer und erweckt ein gewisses Vertrauen. Die Lippensynchronisation ist ein wichtiger Faktor, der die Konzentration des Nutzers verstärkt. Diese ist bei Comicfiguren einfacher umzusetzen als bei menschenähnlichen Assistenten. Ein weiterer Punkt, der das Verstehen von Olga erleichtert, ist die Möglichkeit übertriebene Gestiken anzuwenden. Des Weiteren stellen Gestiken wie das Heben der Augenbrauen, wenn etwas verstanden wurde oder die Darstellung von Emotionen wie das Senken der Antennen, wenn Olga traurig ist eine starke Annäherung an die menschliche Kommunikation dar.Bewertung

Olga kann als Prototyp für weitere Intelligente Assistenten gesehen werden, die in vielen anderen Gebieten Anwendung finden könnten (z.B. Beratung in einer Apotheke, Leitung von Museumstouren, Information über Zugverbindungen). Es ist allerdings fraglich, ob sich für jeden Intelligenten Assistenten die Darstellung einer Comicfigur anbietet. Bei Anwendungsgebieten, die einen hohen Vertrauengrad verlangen (z.B. das Ersetzen eines Versicherungsberaters durch einen Assistenten) könnte diese Darstellung als unseriös empfunden werden. Des Weiteren ist eine vollständige Kommunikation mit dem Benutzer nicht möglich, da der Assistent nur gewisse Schlagwörter versteht.

Hier gibt es das Video zu diesem Thema.

Gehe zu: Themenauswahl, Informationen zum Text

Beispiel: Welbo

Welbo tritt aus dem Bildschirm (Screenshot aus: Welbofilm)

1999 wurde der Intelligente Assistent „Welbo“ von Mixed Reality Systems Laboratory Inc. entwickelt. Dieser wird als Gesprächsagent bezeichnet, der in „mixed-reality-spaces“ lebt.Was bedeutet Mixed Reality?

Frei übersetzt bedeutet „mixed reality“ soviel wie vermischte Realität. Damit ist gemeint, dass sich sowohl reale als auch irreale Objekte in derselben Umgebung befinden. Der Benutzer trägt eine Datenbrille (Head Mounded Display = HMD) und kann dadurch in Echtzeit mit beiden Objektarten interagieren.

Was oder wer ist Welbo?

Welbo in Aktion (Screenshot aus: Welbofilm)

Welbo tritt als virtuelles Objekt aus dem Bildschirm heraus und steht als dreidimensionale Figur mit dem Nutzer in einem Raum. Hier hilft er zum Beispiel bei der Einrichtung eines Wohnzimmers: Er platziert virtuelle Objekte (z.B. eine Vase) nach den Wünschen des Benutzers. Um dieser Aufgabe gerecht werden zu können, ist Welbo mit folgenden Fähigkeiten ausgestattet:- Konversation: Welbo hat nicht nur die Fähigkeit einige vordefinierte Sätze, Meinungen und Einführungen zu sprechen, er kann auch die artikulierten Anweisungen des Benutzers verstehen. Um die Konversation möglichst reibungslos zu gestalten ist es wichtig, dass Welbo auch den Diskurs versteht.

- Verhalten: Welbo handelt nach den Angaben des Benutzers, um Ziele wie zum Beispiel das Verschieben von Möbeln zu erreichen. Des Weiteren ist er in der Lage während einer Kommunikation zu gestikulieren und die Position zu ändern, wenn er auf Instruktionen des Benutzers wartet.

- Bewusstsein: Dieser Intelligente Assistent ist sich nicht nur über seinen Status im Cyberspace und in dem physikalischem Raum (wahren Welt?) bewusst, er erkennt auch die Aktivität des Benutzers und seine Bewegungen.

- Gestaltung: Durch sein Auftreten als Roboter, welches menschenähnlich gehalten wurde, wirkt Welbo vertaut auf den Benutzer und wird somit gut angenommen. Der Körper ist in Echtzeit gerendert und macht den Assistenten somit noch realer. Durch einige Tests in der Entwicklungsphase stellte sich heraus, dass der Nutzer es bevorzugt, wenn Welbo sich immer ganz in ihrem Blickfeld befindet, er nicht auf sie herabschaut und einen gewissen Abstand zu ihnen wahrt.

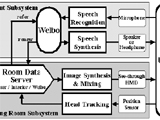

Die Systemarchitektur von Welbo

Welbos Systemarchitektur aus: Anabuki, M. et al.

Diese Abbildung stellt die Systemarchitektur von Welbo dar, welche sich in das „Agent Subsystem” und das „Living Room Subsystem” unterteilt.Das „Living Room Subsystem”:

Das Modul „Head Tracking” misst den Standpunkt und die Blickrichtung des Nutzers mit dem Sensor der Datenbrille. Diese Daten werden in den „Room Data Server“ gesendet, der die virtuelle und reale Umgebungsdaten sowie Welbos Stellung und Lage verwaltet. Die gesamten Daten aus diesem Server werden von der „Image Synthesis & Mixing“ weiterverwendet. Zunächst wird ein digitales Bild hergestellt. Dieses wird dann mit der physikalischen Szene vermischt und auf dem Display der Datenbrille wiedergegeben.

Das „Agent Subsystem“:

Hier befindet sich das Modul, welches Welbo kontrolliert (siehe „Welbo“). Es empfängt nicht nur die Anweisungen des Benutzers über das Modul „Speech Recognition“ sondern auch die Bewegungen des Nutzers werden aus dem „Room Data Server“ herangezogen. Mit diesen Informationen werden die Serverdaten erneuert und das digitale Bild aktualisiert. Des Weiteren werden die Sprachdaten an das Modul „Speech Synthesis“ gesandt, um diese über ein Lautsprecher oder Kopfhörer wiederzugeben.

Bewertung

Die Kommunikation mit Welbo stellt eine Weiterentwicklung in der Technologie der bereits vorgestellten Assistenten dar. Alleine durch die dreidimensionale Präsenz wirkt die Interaktion menschenähnlicher als es zum Beispiel bei Olga der Fall ist. Dennoch sind damit noch längst nicht alle Schwierigkeiten der Kommunikation zwischen Mensch und Maschine behoben. Es bleibt die Frage ob die Komplexität der menschlichen Kommunikation jemals komplett von einer „Maschine“ erlernt werden kann. Die dreidimensionale Darstellung von Welbo habe ich zunächst als positiven Aspekt dargestellt, welcher die Echtheit der Kommunikation fördert. Da die Sympathie so einem „Wesen“ gegenüber allerdings sehr subjektiv ist, könnte Welbo auf manchen Benutzer auch unangenehm wirken.

Hier gibt es das Video zu diesem Thema.

Gehe zu: Themenauswahl, Informationen zum Text

Beispiel: SmartKom

Bisher hörten Maschinen dem Benutzer nicht zu, verstanden zwar seine Befehle und Bedienkombinationen, aber nicht den Menschen und seine Wünsche. SmartKom hört seinem Benutzer zu, und versteht „Wort und Sinn“; es erkennt, ob der Benutzer verärgert ist oder zufrieden und akzeptiert auch Zeigegesten, so dass man ohne Maus und Tastatur seine Ziele erreichen kann.

SmartKom wird als Leitprojekt seit 1999 vom Bundesministerium für Bildung und Forschung (BMBF) mit 16,5 Mio. Euro gefördert.

SmartKom ist eine benutzeradaptive und selbsterklärende Schnittstelle. Durch Benutzermodellierung und Lernverfahren passen sich die Systeme an die verschiedenen Benutzer an. SmartKom wird somit zum persönlichen Assistenten. Die „Kommunikationsagenten“ sind vermenschlicht, da sie als sogenannte „Life-like Characters“ namens „Smartakus“ (ähnlich wie eine Zeichentrickfiguren) visualisiert werden.

Mit SmartKom ist eine nahtlose Integration und eine semantische Verarbeitung von Sprache, Gestik und Mimik, Graphik und sogar Biometrie (weitere wechselseitig ergänzender Eingabemodalitäten) möglich. Auch wenn der Benutzer eine Eingabe tätigt, welche evtl. mehrdeutig, teilweise falsch oder einfach nur ungenau ist, kommt es zu einer „robusten“ Verarbeitung. Zudem bietet SmartKom umfangreiche Hilfe- und Erklärungsfunktionen und zahlreiche metakommunikative Funktionen an.

Drei Anwendungsszenarien von SmartKom:

Drei Anwendungsszenarien (SmartKom - Public ; SmartKom-Mobil ; SmartKom - Home/Office) beinhalten die Grundfunktionalität für die nächste Generation an Benutzerschnittstellen. SmartKom soll komplexe dialogische Interaktionen zwischen dem Benutzer und dem System ermöglichen, dabei können jedoch der Benutzer wie auch das System Rück- und Klärungsfragen stellen, Verständnisprobleme aufzeigen und auch den Dialogpartner unterbrechen. Zudem stellt SmartKom einen Zugang zu Problemlösungen bereit.

1. SmartKom - Public (Multimodale Kommunikationszelle)

SmartKom - Public ist die Weiterentwicklung traditioneller und öffentlicher Telefonzellen für den Bürger der modernen Wissensgesellschaft. Sie dient als eine multimodale Kommunikationszelle für Breitbandkommunikation.

In der Abbildung ist die Designstudie zu der Kommunikationszelle zu sehen. Diese Kommunikationszelle verfügt über eine breite Palette modernster Kommunikationsendgeräte. Dazu gehören z.B. eine Dokumentenkamera und ein Bildschirmtelefon. Diese Zelle ist gegen eine Gebühr zugänglich. Die Gebühr kann über eine Kreditkarte bezahlt werden. Die Zelle bietet im Gegensatz zu normal öffentlicher Mobilkommunikation Vertraulichkeit, da sie abgeschlossen werden kann. Ein PDA, ein Camcorder oder sonstige Benutzergeräte können durch mehrere Anschlussmöglichkeiten in der Zelle an das System angeschlossen werden. So kann auf persönliche Daten zugegriffen werden oder aktuelle Daten können abgespeichert werden. Zudem können Videos oder Bildmaterial übermittelt werden. In der Zelle befindet sich der Kommunikationsraum, welcher die gleichzeitige und komfortable Benutzung von Sprach-, Bild- und Datendiensten (z.B. Bildschirmtelefon, Internet-Zugang, Surfen in lokalen Informationsdiensten) gewährleisten soll. Dabei können z.B. Informationsseiten während des Gesprächs ins Bildschirmtelefon eingeblendet werden. Zusätzlich werden in dem Kommunikationsraum Scanner oder Dokumentenkameras integriert. Durch eine persönliche Chipkarte soll eine automatische Verbindung zum Büro- oder Heim - PC herstellbar sein (befindet sich noch in Planung), um so auf den persönlichen Arbeitsplatz zuzugreifen. In Planung befindet sich auch die Möglichkeit die aktuelle Arbeitsumgebung des Benutzers in der Kommunikationszelle abzuspeichern. Der Benutzer soll dann die Oberfläche der Kommunikationszelle so vorfinden, wie er sie zuletzt verlassen hat.

Mit SmartKom soll die Idee eines virtuellen Kommunikationsplatzes umgesetzt werden, welcher persönlich auf den Benutzer abgestimmt und ständiger Begleiter dessen ist. Dabei wird eine multimodale Kommunikation im Vordergrund stehen.

Bedienung:

Da es sich um einen Kommunikationsraum für die Öffentlichkeit handelt, ist die Bedienung der Kommunikationszelle und deren Einfachheit wichtig für die Akzeptanz von SmartKom in der Gesellschaft. Auch Personen, die zu Hause keinen Computer mit einem ähnlichen System besitzen, sollen Benutzer von SmartKom - Public werden. Die Mensch – Maschine - Schnittstelle sollte in ähnlicher Weise gestaltet sein, wie Menschen normalerweise miteinander kommunizieren. Das heißt, sie sollte möglichst freie sprachliche Dialoge führen können und den Gebrauch natürlicher Gesten gebrauchen. Eventuelle Störungen, die umgebungsbedingt (z.B. Lärm, Staub) oder benutzerbedingt sein (z.B. Heiserkeit) können, müssen ausgeschlossen und behoben werden.

2. SmartKom-Mobil (Mobiler Kommunikationsassistent)

Wir leben in einer Gesellschaft, die sich ständig neu modernisiert. Dabei ist Mobilität wichtig. Das bedeutet körperliche Mobilität und kontinuierlicher Zugriff zu Information zu jeder Zeit und überall. SmartKom - Mobil ist ein persönlicher und ständiger Begleiter im Büro, in der Wohnung, im Auto oder auch zu Fuß.

In der Abbildung (siehe unten) ist die Designstudie zu SmartKom - Mobil dargestellt. Es ist ein tragbarer Rechner, der dann beispielsweise über eine Funkverbindung kommunizieren kann.

Mit SmartKom - Mobil kann der Benutzer beispielsweise den Zugang zum Internet nutzen. Über eine GSM-Verbindung besteht Internet-Zugang und durch ein integriertes GPS kann die Eigenbewegung auf digitalen Karten verfolgt werden. Ein Display und Lautsprecher sind für die Ausgabe der Informationen zuständig. Durch ein Mikrofon (am linken Rand des Gerätes zu sehen) kann ein Dialog in gesprochener Sprache geführt werden. Mit einer integrierten Kamera (oberer Rand des Gerätes), kann die Mimik des Benutzers erfasst werden. Mit einem Stift können Handschrift oder Zeigegesten koordiniert mit Sprache eingegeben werden.

Die Möglichkeiten von Informations- und Kommunikationsnetzen sollen durch SmartKom genutzt werden, um für den Benutzer interessante oder nützliche Informationen jederzeit und überall zusammenzutragen ( Wetterbericht oder Hotelreservierung).

Auch SmartKom – Mobil soll von der Öffentlichkeit genutzt werden. Eine persönliche und einfache Kommunikation muss daher möglich sein. Dazu gehört beispielsweise, dass SmartKom - Mobil persönliche Assistenzfunktionen übernehmen kann. Eine biometrische (also ohne PIN und Passwörter) Zugangskontrolle wird deshalb unerlässlich sein (siehe Abbildung: Sensor für den Fingerabdruck unten links). Somit kann wirklich nur der Benutzer Zugriff auf SmartKom – Mobil nehmen.

Ein wesentlicher Aspekt von SmartKom - Mobil liegt dabei in der benutzerzentrierten Mensch-Maschine-Interaktion. Das Spracherkennungs- und Dialogsystem passt sich an die Gewohnheiten, Vorlieben, und Ausdrucksweisen an. Obwohl eine natürlich, gesprochene Sprache besonders vorteilhaft ist, sollen auch andere Ein- und Ausgabemodalitäten vorgesehen werden. Einige Informationen sind zudem einfacher über Bilder, Graphiken oder Gesten für den Benutzer zu verstehen. Im Auto während der Fahrt sind vor allem gesprochene Dialoge sinnvoll, da graphische Informationen zu Gefährdungen des Verkehrs führen können. Auch im Auto soll SmartKom - Mobil nicht nur zur Navigation, sondern auch zur Steuerung von Informationsdiensten, Internet und Mehrwertdiensten (z.B. Park & Ride Lotsendienst) eingesetzt werden.

Designstudie zu SmartKom - Mobil

Es sollte mit SmartKom – Mobil möglich sein, im Rahmen eines Dialogs die problemlose Einbindung von Stifteingabe oder auch die Mischung von gesprochener und geschriebener Ausgabe sein. Auch die verschiedenen Umwelthinweise sollte das System auf situative Kontexte durch zusätzliche Kommunikationskanäle erschließen können.3. SmartKom - Home/Office

Designstudie zu SmartKom – Home/Office

Durch SmartKom - Home/Office wird ein persönlicher Computerarbeitsplatz geschaffen. Dieser ähnelt stark einer Steuerzentrale der vernetzten Wohnumgebung. Die Funktionalität dieses Arbeitsplatzes beschränkt sich dabei nicht nur auf normale Computeranwendungen wie Adressverwaltung, Dokumenterstellung oder Tabellenkalkulation und den Zugriff auf Informationsdienste (z.B. Wetterinformation, Fahrplanauskunft oder Navigation im Internet). Sie stellt eine Benutzerschnittstelle zu vielen Geräten der Unterhaltungselektronik (z.B. Hifi-Anlage, Fernseher, Videorecorder) sowie zur Steuerung der Wohnumgebung (z.B. Beleuchtung, Temperatur) zur Verfügung.In der obigen Abbildung ist ein berührungssensitiver Bildschirm zu sehen, der als Ein- und Ausgabemedium dient. Auf dem Bildschirm ist der personalisierte Kommunikationsagent oder auch Life – like – Character „Smartakus“ zu erkennen. Auch SmartKom - Home/Office verfügt über ein Mikrofon (links vom Bildschirm in Abbildung zu sehen) und eine Kamera. Dieser personalisierte Kommunikationsagent ist besonders wichtig für die Handhabung des Systems. Er verschafft dem Benutzer einen besseren Überblick über das System.

Alle Geräte und Dienste werden von einer einheitlichen Dialogoberfläche gesteuert. Bei SmartKom sind alle natürlichen Kommunikationsformen wie Sprache, Gesten, Mimik oder auch Handschrift möglich. Im SmartKom – Home/Office kann der Benutzer einen Videorecorder programmieren, indem er entweder per Stimme fordert "Die Sportschau auf dem ZDF heute Abend aufnehmen" oder in einer elektronischen Fernsehzeitschrift mit dem Finger auf eine ausgewählte Sendung zeigt und sagt: "Bitte diese Sendung aufnehmen". Somit erfolgt die Interaktion mit sprachlichem Dialog, durch Zeigen und in bildlicher Form. Die Maschine muss also fähig sein, die Gewohnheiten des Benutzers zu erlernen. Die Dialogführung sollte flexibel sein, sodass unvollständige oder vage Äußerungen des Benutzers auch erkannt werden und er durch intelligente Hilfefunktionen durch die Systemfunktionalität geführt wird.

Multiple Medien, Modalitäten und Codes

„Medium“, „Modalität“ und „Code“ sind für SmartKom von zentraler Bedeutung, da hier eine Definition dieser Grundbegriffe im Kontext der Mensch-Technik-Interaktion vorgenommen wird.

Medium:

Als Medium bezeichnet man den physikalischen Informationsträger. Dieser ist zur Übertragung, Präsentation oder Speicherung von Information da. Dies können z.B. Ein- und Ausgabegeräte von Computern sein (wie Mikrofon, Lautsprecher, Bildschirm, Stift, Tastatur, Kamera oder Maus).

Modalität:

Mit Modalität sind die menschlichen Sinne gemeint, die dazu dienen, eingehende Information zu erfassen und zu verarbeiten. Ein Mensch besitzt also visuelle und akustische Wahrnehmungsfähigkeiten. In SmartKom spielt der Begriff Modalität auf der Ein- und Ausgabeseite des Systems eine Schlüsselrolle.

Code:

Mit dem Begriff Code wird auf ein Symbolsystem mit eigenständiger Syntax, Semantik und Pragmatik verwiesen.

Medium, Modalität und Code

Wichtig ist, dass Medium, Modalität und Code nicht auf eine triviale Weise miteinander verknüpft sind (siehe Abbildung unten).In SmartKom werden vier verschiedene Codes als Zeichensysteme verwendet: Sprache, Graphik, Gestik und Mimik.

Die Codes können auf der Ein-, Ausgabeseite unterschiedliche Modalitäten nutzen. Sprache kann also visuell (auf dem Medium Bildschirm) oder akustisch (durch einen Lautsprecher) ausgegeben werden. Die Eingabe von Sprache kann u.a. akustisch (über Mikrofon), gestützt durch visuelle Eingabe (Kamera mit Lippenlesen) oder taktil (über Tastatur) erfolgen.

Grobarchitektur von SmartKom

Grobarchitektur von SmartKom

Charakteristisch für den Ansatz von SmartKom ist, dass die Aspekte der multiplen Codes und multiplen Modalitäten im Zusammenhang mit dialogischer Interaktion eindeutig im Mittelpunkt stehen.In der obigen Abbildung wird die Grobarchitektur SmartKoms gezeigt. SmartKom ist eine wissenbasierte Schnittstelle, die auf expliziten Modellen der Benutzer, der Diskursstruktur, der Domäne und der darin gestellten Aufgabe sowie der verfügbaren Medien beruht.

Es gibt vier Hauptkomponenten von SmartKom:

- die modalitätsspezifischen Analysatoren

- die multimodale Interaktionskomponente

- die Anwendungsschnittstelle mit explizitem Anwendungsmodell

- multimodale Mediendesign für die Ausgabeplanung.

Bewertung

SmartKom ist ein interaktiv kommunizierendes System, dass sozial und proaktiv mit dem Benutzer kommuniziert. Es soll der modernen Gesellschaft große und vielseitige Mobilität bieten (siehe drei verschiedene Assistenzmöglichkeiten). Mit SmartKom soll die Idee eines virtuellen Kommunikationsplatzes umgesetzt werden, welcher persönlich auf den Benutzer abgestimmt ist und zu seinem ständigen Begleiter wird. Ein System indem die Eingabe über Sprach- und Gestenerkennung erfolgt, wird zunehmend denkbar und wird bei SmartKom präsentiert. Es kann sich auf die verschiedenen Fähigkeiten und Bedürfnisse der Menschen einstellt und soll im Alltag für die Gesellschaft zum Normalzustand werden. Dabei ist immer wieder wichtig, dass die Bedienung leicht und gut zu erlernen ist. Wobei sich die Frage stellt, ob SmartKom überhaupt umsetzbar ist? Nicht jeder Benutzer könnte vielleicht mit dem System umgehen. Muss viel erlernt werden um mit „Smartakus“ zu kommunizieren? Wenn der Arbeitsplatz überall mitgenommen werden kann, brauchen wir dann überhaupt noch Büros? Wie finanziert der einzelne Benutzer SmartKom?

Diese Fragen müssen bei SmartKom bedacht werden. Ansonsten bringt uns SmartKom einen großen Schritt weiter zur Mensch – Maschine – Interaktion.

Hier gibt es das Video zu diesem Thema.

Gehe zu: Themenauswahl, Informationen zum Text

Beispiel: Fahrerassistenzsysteme

Sie unterstützen den Fahrer indirekt, indem sie den Fahrer über die Situation informieren und vor Gefahren warnen. Der Fahrer soll an Übersicht gewinnen und so bessere Entscheidungen treffen können. Fahrerassistenzsysteme haben keine Kontrolle über das Fahrzeug und können jederzeit abgeschaltet werden. Die Verantwortung liegt weiterhin beim Fahrer.

Fahrassistenzsysteme:

Auswahl von Beispielen

Sie wirken wenn nötig direkt, ohne dass der Fahrer es noch verhindern könnte und wirken im Hintergrund so, dass der Fahrer es evt. gar nicht merkt und die Auswirkungen für normal hält. Sie müssen schnell und präzise arbeiten und werden oft durch Mikrocomputer gesteuert. Als wesentliches Merkmal ist zu den Fahrassistenzsystemen noch zu sagen, das sie, wenn sie aktiv werden, die Kontrolle über das Fahrzeug haben. Diese Systeme sind schon als intelligent zu bezeichnen, da sie eigenständig handeln und das Fahrzeug führen können.ABS

Das bekannteste System ist sicherlich das Antiblockiersystem ABS. Seitdem dieses System eingeführt wurde, hat sich auf dem Sektor einiges getan. Heutzutage gehört ABS schon zum Standard, ja es ist sogar in Europa bei neu zugelassenen PKW seit Mitte 2004 Pflicht. Das Anti-Blockier-System soll beim Bremsen übergroßen Schlupf zwischen Reifen und Fahrbahn vermeiden und damit die Lenkfähigkeit und die Seitenführung erhalten. Raddrehzahlsensoren überwachen ständig alle Räder. Neigt ein Rad zum Blockieren, greift das ABS blitzschnell ein und reduziert den Bremsdruck an diesem Rad, so dass es nicht vollständig zum Stehen kommt. ABS führt diesen Regelvorgang für jedes Rad einzeln durch. Diese elektronische Radschlupfregelung sorgt so für die Lenkbarkeit und erhöht die Stabilität des Fahrzeugs.

ESP

Das Elektronische Stabilitäts-Programm erkennt in Millisekunden eine drohende Instabilität des Fahrzeugs. Mit einem aktiven Eingriff in den Antriebsstrang oder in das Bremssystem hält ESP das Fahrzeug stabil und das Fahrzeug bleibt sicherer in der Spur. Mittlerweile wird das ESP in den meisten LKWs auch serienmäßig eingebaut. Für nähere Informationen klicken sie hier.

ACC

Die Adaptive Cruise Control (ACC) ist ein Fahrerassistenz-System, das auf dem Geschwindigkeitsregler aufbaut. ACC bremst und beschleunigt in Abhängigkeit vom Verkehrsfluss in gewissen Grenzen selbstständig. Dazu überwacht ACC mit einem Radarsensor den Raum vor dem Fahrzeug. Detektiert das System ein langsamer vorausfahrendes Fahrzeug, senkt es die Geschwindigkeit des eigenen Fahrzeugs so weit ab, dass es in einem definierten Abstand folgt. Ist die Fahrbahn vor dem eigenen Fahrzeug wieder frei, so beschleunigt ACC auf die eingestellte Geschwindigkeit. Das heutige System ist für den Betrieb auf Autobahnen und Schnellstraßen ausgelegt. Zukünftige Systemgenerationen werden den Einsatzbereich bis hin zum Stadtverkehr erweitern.

Einparkassistent

Schaltet der Fahrer das System ein, aktiviert er einen zur Seite gerichteten Ultraschallsensor. Dieser misst bei gemäßigter Vorbeifahrt die Lücken am Straßenrand aus. Länge und Tiefe werden dabei ebenso erfasst – und mit den Abmessungen des eigenen Autos abgeglichen. Passt die Parklücke, geht es ans Einparken. Der Einparkassistent berechnet den optimalen Weg in die Lücke. Auf Knopfdruck bringt der Assistent den Fahrer mühelos in die Lücke. Hat das Auto eine elektrische Lenkung, übernimmt der Einparkassistent dabei sogar das Kurbeln am Lenkrad. Mit einem Griff ans Lenkrad kann der Fahrer den Einparkassistenten natürlich auch jederzeit abschalten.

Spurverlassenswarner (LDW – Lane Depature Warning) und Spurwechselassistent (LCA – Lane Change Assistant) warnen vor dem unbeabsichtigten Verlassen der Fahrspur und unterstützen beim Fahrspurwechsel.

Nachtsichtassistenten

Aktive Nachtsichtsysteme setzen dazu auf Infrarot-Technik. In die Hauptscheinwerfer wird ein zusätzlicher Infrarotscheinwerfer eingebaut, der im Wellenlängenbereich knapp unterhalb des sichtbaren Lichts strahlt und deshalb für das menschliche Auge unsichtbar bleibt. Es erreicht eine Leuchtweite von rund 150 Metern - ungefähr so weit wie Xenon-Fernlicht. Eine Kamera hinter der Windschutzscheibe nimmt diesen ausgeleuchteten Bereich auf, bearbeitet das Bildmaterial digital und zeigt das Geschehen vor dem Auto als reales schwarz-weiß Bild. Im Nachtsichtbild sind Hindernisse unabhängig von Ihrer Temperatur sichtbar. Auch Fahrbahnmarkierungen und Verkehrsschilder sind deutlich zu sehen. Weitere Informationen zu diesem Thema finden sie hier.

Bewertung

Schon heutzutage werden viele Assistenzsysteme verwendet, in der Zukunft wird es neue Systeme mit immer mehr Kontrolle über das Fahrzeug geben.

So gern wir alle das Auto auch benutzen, ist es dem Menschen von Natur aus kaum möglich, Geschwindigkeiten von mehr als 30 km/h sicher zu beherrschen. Wenn man nun bedenkt, wie schnell unsere modernen Autos sind und welche Leistung sie haben, kann einem eigentlich nur angst und bange werden. Da man nicht auf Geschwindigkeit und PS-Wahnsinn verzichten möchte, versucht man mittels Fahr(er)assistenzsystemen die durch die menschlichen Unzulänglichkeiten entstehenden Unfälle zu vermeiden. Durch die Unterstützung und Entlastung des Fahrers kann der Fahrkomfort und die Verkehrssicherheit gesteigert werden. In der NHTSA (Web based Encyclopedia) stand 2001 folgendes: „Weniger als 3% aller Unfälle sind auf technische Mängel zurückzuführen, 97% auf ein Fehlverhalten des Fahrers.“ Eine Perfektion der Fahr(er)assistenzsysteme hätte die Vision vom automatischen und unfallfreien Fahren zur Folge!!

Allerdings muss man, gerade dann, auch einige Nachteile bedenken:

Der Fahrer eines PKW steckt in einem Dilemma. Die Sicherheitssysteme geben dem Fahrer immer mehr Informationen die er verarbeiten muss. Auf der anderen Seite soll sich der Fahrer auf das Wesentliche konzentrieren. Wird der Fahrer dadurch nicht überfordert? Er ist schließlich keine Maschine! Der Fahrer soll sich im Auto sicher fühlen. Wird er dadurch vielleicht leichtsinnig? Überschätzt man sich in einem Auto das vermeintlich alles kann?

Der Fahrer soll entlastet werden. Das kann manchmal sicherlich zur Müdigkeit führen, wenn man an das Adaptive-Cruise-Control denkt. Dabei braucht der Fahrer kaum noch etwas machen. Nur gut, das es auch Systeme gegen Müdigkeitsunfälle gibt. Auch verändert sich die Interaktion des Menschen mit dem Fahrzeug. Der Fahrer wird von der Bedienung entwöhnt. Dieses kann zu einem Erfahrungsverlust führen, sowie gegebenenfalls bei Funktionsverlust des Fahrerassistenzsystems zu der Notwendigkeit, dass der Bediener dann Tätigkeiten ausführen muss, die er oder sie nicht mehr mit der nötigen Routine oder Kraft ausführen kann.

Kann man Assistenzsysteme für alle Eventualitäten entwickeln und dem Fahrer die letzte Entscheidung abnehmen? Man denke an ein Bahngleis auf dem man steht und die Bahnschranken vor und hinter einem sind geschlossen. Der Mensch würde sicher versuchen durch die Schranke zu fahren, wenn ein Zug kommen würde. Das geht aber leider nicht, weil das automatische Abstandshalte-System das verhindert. Fahrerassistenzsysteme nehmen die Freiheit, gegen die einprogrammierten Regeln zu fahren.

Was passiert, wenn der Fahrer erschöpft ist? Soll der Fahrer dann gezwungen werden anzuhalten und die Zündung blockiert werden oder soll der viel zu müde Fahrer trotzdem weiterfahren können und das System versuchen, den Fahrer und seine Umwelt so gut es geht zu schützen?

Wie sieht es rechtlich aus? Wer hat Schuld, wenn ein Unfall passiert? Der Fahrer oder der Hersteller des Assistenzsystems? Wer ist dann Verantwortlich?

Hier und hier gibt es das Video zu diesem Thema.

Gehe zu: Themenauswahl, Informationen zum Text

Diskussion

An dieser Stelle sollen ein paar Diskussionspunkte angesprochen werden, die einem bei der Beschäftigung mit Intelligenten Assistenten ins Auge fallen.

Schon die Definition eines Intelligenten Assistenten erweist sich als schwierig. Was genau ist unter intelligentem Handeln zu verstehen? Schließt Intelligenz Autonomie mit ein und ist ein Intelligenter Assistent somit ein autonom handelndes Wesen? Wo liegen die Abgrenzungen zur künstlichen Intelligenz, wo liegen die Grenzen zum Menschen? Da diese Fragen auch in der Wissenschaft umstritten sind, ist die Intention an dieser Stelle nicht ihre Beantwortung. Es sollen lediglich Denkanstöße gegeben werden. Das größte Problem stellen die unterschiedlichen Rahmenbedingungen dar. Der Begriff der „Autonomie“ oder der „Intelligenz“ umfasst im Bezug auf Menschen viel mehr, als wenn man ihn auf Maschinen anwendet. Man kann eine Maschine nicht auf dasselbe Niveau eines Menschen stellen, oder etwa doch? Des Weiteren sind die Menschen eher weniger bereit, sich auf die Ebene einer Maschine herabsetzen zu lassen.

Auch die Funktionen eines Intelligenten Assistenten lassen einige Fragen aufkommen:

Wo genau liegt der Unterschied von Reaktanz und Proaktivität bei einer Maschine? Kann ein Intelligenter Assistent wirklich eigenständig etwas tun ohne auf irgendetwas zu reagieren, und sei es der Programmcode? Es würde den Intelligenten Assistenten ja gar nicht geben, gäbe es nicht seinen Programmierer, der ihn mit all seinen Fähigkeiten ausgestattet hat. Somit könnte alles, was der Intelligente Assistent macht, als eine Reaktion innerhalb seiner eingebauten Funktionen auf eine oder mehrere eingebaute Reaktionen gesehen werden? Des Weiteren stellt sich die Frage, ob man schon von einem Intelligenten Assistenten sprechen kann, wenn dieser lediglich Hinweise oder Warnungen gibt?

Ähnliche Fragen stellen sich bei der Funktion der Lernfähigkeit. Beinhaltet der Begriff der Lernfähigkeit nicht auch in einem gewissen Sinne Selbstständigkeit? Ist es dann richtig von einem lernfähigen System zu sprechen? Sicherlich können manche Intelligente Assistenten in einem bestimmten Umfeld für sie bzw. ihren Programmcode, relevante Neuheiten lernen. Aber wieder ist es der Programmierer, welcher den Rahmen vorgibt und bestimmt was genau gelernt werden soll und kann. Oder wird es irgendwann einen Intelligenten Assistenten geben, der alles „von allein“ lernen kann, fast wie ein Mensch? An dieser Stelle würde sich die Frage ergeben, ob wir Menschen das überhaupt wollen. Gibt es nicht Sachen, die Maschinen lieber nicht lernen sollten? Auch Emotionen gehören zu einem Lernprozess dazu, da diese häufig wichtig für das richtige Verstehen eines Kontextes sind. Doch wie soll man eine Maschine dazu bringen, diese selbstständig zu erlernen, wenn wir die gesamte Komplexität der Gefühle beim Menschen schon nicht erfassen können?

Vor allem die soziale Funktion eines Intelligenten Assistenten ist schwer vorstellbar. Die Mensch - Maschine Kommunikation bringt noch einige Schwierigkeiten mit sich. Die Aussprache des Menschen ist für die Maschine nicht immer deutlich genug, das Vokabular des Menschen ist sehr groß und erweitert sich manchmal sogar, das selbe Wort kann in einem anderen Kontext oder lediglich mit einer anderen Betonung eine vollkommen neue Bedeutung erhalten und so weiter.

Weiterhin ist es auch fraglich, ob sich Intelligente Assistenten in der heutigen Welt durchsetzen würden. Würden wir Menschen Maschinen akzeptieren, die uns Arbeit erleichtern oder hätten wir zu viel Angst oder Respekt um den Intelligenten Assistenten eine Chance zu geben?

Eine weitere wichtige Frage die sich stellt betrifft die Finanzierung solcher „Geräte“. Diese wird, je komplexer der Assistent gestaltet ist, nicht für jedermann erschwinglich sein. Würde mit einer sehr teuren Vermarktung somit nicht das Problem der Zwei-Klassen-Gesellschaft verschärft? Ist es realisierbar manche Intelligente Assistenten, wie beispielsweise einige der Fahrerassistenzsysteme, für die Menschen zur Pflicht zu machen? Wer trägt dann bei Fehlern die Verantwortung? Der Nutzer? Der Programmierer? Der Hersteller? Oder die Maschine?

Falls Intelligente Assistenten in den Alltag eingeführt werden sollen müssen viele Fragen bedacht und Vor- und Nachteile abgewogen werden. Ein Intelligenter Assistent kann ein Menschenleben erleichtern, aber man muss auch die Gefahren bedenken. Je mehr Technik vorhanden ist, desto mehr Fehler gibt es in technischen Systemen.

Inwiefern würde sich der Mensch in eine Abhängigkeit begeben, die ihn auf Dauer Fähigkeiten verlernen lässt, die ihm schließlich der Intelligente Assistent abnimmt? Und was passiert wenn dann das technische System versagt? Kann man dann noch vom Menschen als autonomes Wesen sprechen?

Gehe zu: Themenauswahl, Informationen zum Text

Autoren: Annika Knicker, Kathrin Schielke, Lena Tetzlaff

Quellen

- Herfert: „With a little Help of My Friends“, 2006, HU Berlin, Institut für Psychologie, Prof. Hartmut Wandke

- von Guretzky, Bernhard: Wissensmanagement und Software Engineering -Expert Assistance-. www.community-of-knowledge.de, Stand: 18.06.2007

- Anabuki, Mahoro; Kakuta, Hiroyuki; Yamamoto, Hiroyuki; Tamura, Hideyuki: Welbo: An Embodied Conversational Agent Living in Mixed Reality Space. www.ritsumei.ac.jp, Stand: 18.06.2007

- Fahrerassistenzsysteme: Innovationen für Sicherheit, Deutscher Verkehrssicherheitsrat e.V., www.bester-beifahrer.de, Stand: 26.06.2007

- Christaller, Thomas; Wehner, Josef: Autonomie der Maschinen, Westdeutscher Verlag, Wiesbaden, 2003

- Deutsches Forschungszentrum für Künstliche Intelligenz GmbH: Prof. Dr. Dr. h.c. mult. Wolfgang Wahlster, smartkom.dfki.de, Stand: 26.06.2007

- EuProDat-Online-Redaktion: www.hypercard.de, Stand: 25.06.2007

- www.open-video.org

Gehe zu: Themenauswahl